Der Einsatz von Künstlicher Intelligenz in der Textgenerierung, vor allem durch Programme wie ChatGPT, sorgt für zahlreiche Diskussionen und Kritik. Während die Technologie beeindruckende Texte produzieren kann, stellt sich die Frage, wie sinnvoll das ist.

Im Unterschied zu klassischen Algorithmen, die feste Regeln befolgen, arbeitet ein KI-System wie ChatGPT statistisch: Es erzeugt Antworten basierend auf Wahrscheinlichkeiten und Mustern in riesigen Datenmengen, nicht auf festgelegten Abläufen. Während eine traditionelle Software etwa Lagerbestände verwaltet, erkennt KI wie ChatGPT Muster, um Vorhersagen oder neue Inhalte zu generieren. Generative KI wird dabei durch Eingaben („Prompts“) angestoßen, liefert aber oft variable Ergebnisse, da sie nicht einem festen Ablauf folgt – genau erklären, wie ein Ergebnis entsteht, kann sie daher nicht. Jeder Prompt liefert ein anderes Ergebnis, manchmal auch mit widersprüchlichem Inhalt.

Inhalt

KI ohne Wahrheitsanspruch

Die grundlegende Funktionsweise von ChatGPT und vergleichbaren Sprachmodellen basiert darauf, Texte zu erzeugen, die statistisch den menschlichen Dialog nachahmen. Doch diese Programme haben kein echtes Verständnis von Wahrheit oder Bedeutung. Stattdessen produzieren sie Antworten auf Basis von Wahrscheinlichkeiten, nicht aufgrund einer Überprüfung auf Fakten.

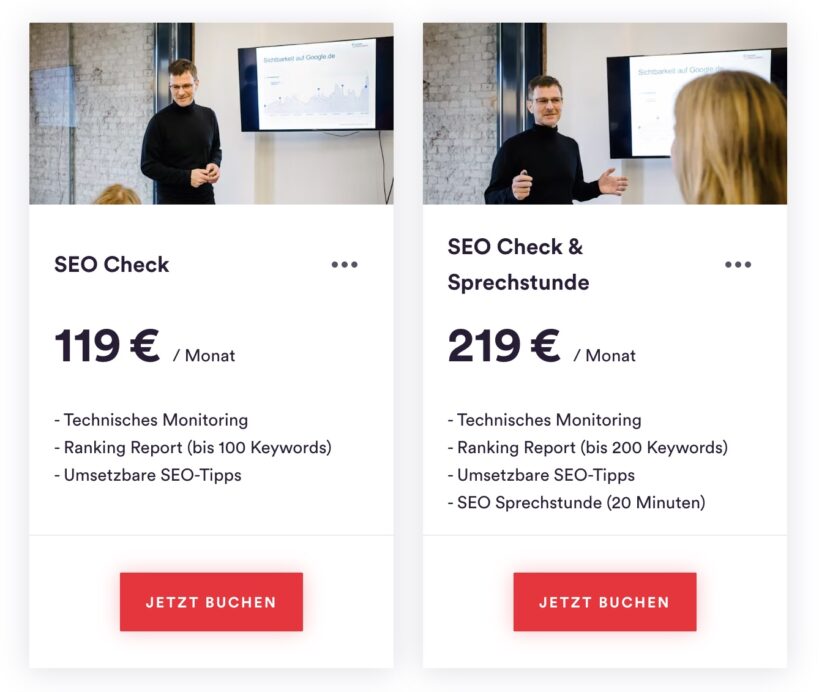

SEO Beratung von ContentConsultants

Steigern Sie Reichweite und Umsatz mit nachhaltiger Content-Strategie.

Leistungen im Überblick:

- SEO- & KI-Strategie – Maßgeschneiderte Inhalte für mehr Reichweite in Suchmaschinen

- Keyword- & Wettbewerbsanalyse – Kontinuierliche Optimierung Ihrer Inhalte

- Contentproduktion – Erstellung & Anpassung nach Google-Richtlinien

- Website Management – Kontinuierliche Pflege direkt im CMS (optional)

- Monitoring & Reporting – Regelmäßige Analyse von Technik & Performance

- Schulungen & Workshops – SEO-, Content- & KI-Wissen für Teams

Die Forscher Michael Townsen Hicks und seine Kollegen von der Universität Glasgow beschreiben den Output sogar als „Bullshit“: ChatGPT sei „indifferent gegenüber der Wahrheit seiner Aussagen.“ KI-Systeme könnten daher unabsichtlich falsche Informationen verbreiten, weil sie sich lediglich daran orientieren, was sprachlich plausibel erscheint, nicht daran, was faktisch richtig ist.

„Halluzinationen“ oder strategischer Einsatz?

Zwar sind KI-Fehler oft als „Halluzinationen“ beschrieben worden – ein Begriff, der suggeriert, dass die KI schlicht einen „Wahrnehmungsfehler“ mache. Doch die Wissenschaftler kritisieren diese Wortwahl als irreführend. Denn die KI „halluziniert“ nicht wie ein Mensch; sie erzeugt schlicht irgendwelche wahrscheinlich klingende Aussagen ohne Bezug zur Wahrheit und ohne jedes Interesse daran. Wir können KI nicht verantwortlich dafür machen, wenn sie Lügen und Halbwahrheiten verbreitet und wir erkennen das aufgrund der perfekt scheinenden Antworten in vielen Fällen auch gar nicht.

Der Informatiker und KI-Kritiker Jürgen Geuter mahnt zur Vorsicht: „Diese Maschinen sind keine denkenden Wesen.“ Stattdessen sind sie komplexe Werkzeuge, die auf menschlichen Eingaben basieren und nur so gut sind wie die Daten, die sie füttern. Problematisch wird dies insbesondere, wenn solche KI-Anwendungen als glaubwürdige Quellen herangezogen werden, zum Beispiel in journalistischen oder wissenschaftlichen Kontexten.

Der „Selbstversorgungs-Kreislauf“ und seine Folgen

Ein weiteres Problem entsteht durch die immer größere Menge KI-generierter Inhalte, die wiederum zur Fütterung neuer KI-Modelle genutzt werden. Geuter bezeichnet diesen Prozess als „inzestuös“. Diese „Selbstversorgung“ der KI mit maschinengenerierten Daten mindert langfristig die Qualität, weil immer weniger echte menschliche Perspektiven einfließen. Das könnte dazu führen, dass die „Informationsdichte“ in den Texten sinkt, was wiederum die Fähigkeit der KI, nützliche Informationen zu generieren, einschränkt.

Mehr Sichtbarkeit in Suchmaschinen – ohne Streuverluste.

☞ Jetzt unverbindliche SEO-Erstberatung anfragen.

Suche ich beispielsweise auf Perplexity nach meinem Namen, sehe ich einen sehr positiven Beitrag über meine eigenen Leistungen. Schaue ich auf die Quellen, stelle ich fest, dass Perplexity alle Informationen nur von meinen eigenen Plattformen, also Website, Linkedin und Gastartikeln zusammen gestellt hat. Kritische Distanz? Fehlanzeige. Auch wenn in diesem Fall jedes Wort selbstverständlich wahr ist (*Ironie off*), stellt sich also die grundsätzliche Frage, ob man sich wirklich auf die Beurteilung einer generative KI verlassen sollte.

Damit KI reibungslos funktioniert, ist es nötig, Menschen darauf zu konditionieren, regelmäßig KI zu nutzen, zu behaupten, dass man künftig überflüssig werde, wenn man keine KI-Tools einsetze und Nutzer zu willigen Multiplikatoren dieser Agenda zu machen. Selbsternannte “KI-Experten” erledigen diesen Job für die Unternehmen und propagieren deren Agenda.

Kritik an den Folgen dieser Modelle wird von den Anbietern häufig als Fortschrittsfeindlichkeit abgetan. Oder man betont ganz bewusst nur die positiven Aspekte der neuen Technologie, um die latenten Gefahren für viele Menschen zu verdrängen. In der Psychologie nennt man dieses Prinzip “Gaslighting”.

Ein Beispiel für diese Strategie, Kritik aus der eigenen Branche einfach mit “positive thinking” aus dem Weg zu gehen, liefert der deutsche KI-Unternehmer Richard Socher, der seine eigene “Produktivitätsmaschine” You.com vermarkten möchte, die aber auch nichts anderes macht, als fragwürdige Zusammenfassungen von mehr und auch weniger relevanten Inhalten aus dem Netz zu generieren. Man muss nur fest daran glauben, dann wird alles gut.

Nebenwirkungen und Risiken von generativer KI auf unsere Gesellschaft

Die Auswirkungen auf den Arbeitsmarkt sind weitreichend. KI wird oft als Lösung für Fachkräftemangel propagiert, etwa im Kundenservice oder Journalismus. Geuter sieht hier eine „toxische Dynamik“ am Werk: Unternehmen könnten durch den Einsatz von KI weniger qualifizierte Arbeitskräfte beschäftigen und diese dann unter Druck setzen, dass die KI ihre Arbeit ersetzen könnte. Dabei geht es häufig nicht um Qualitätssteigerung, sondern um Kosteneinsparung – „die Qualität des Outputs ist dann oft zweitrangig, Hauptsache, er ist billig.“

Neben diesen Herausforderungen gibt es weitere ungelöste Probleme im Umgang mit KI, die bedeutende Auswirkungen haben können.

Ein wichtiger Punkt ist die Frage der Verantwortung: Wer haftet eigentlich, wenn KI-Systeme wie ChatGPT falsche oder irreführende Informationen liefern? Besonders in sensiblen Bereichen wie Medizin oder Recht kann dies schwerwiegende Folgen haben. Auch urheberrechtliche Fragen sind bislang völlig ungeklärt. KI verarbeitet aus dem Netz zusammengesammelte Informationen bisher ohne das Einverständnis der Urheber.

Umgekehrt sind KI-generierte Inhalte nicht urheberrechtlich schützbar, können also kostenlos und ohne Einschränkung immer weiter verwertet werden. Das könnte ein zentrales Recht, das kreativen Menschen einen Lebensunterhalt sichert, dauerhaft gefährden.

INSERT_STEADY_NEWSLETTER_SIGNUP_HERE

Die Proteste gegen KI werden lauter

Es gibt bereits massiven Widerstand aus der Kreativbranche gegenüber der Nutzung von KI. So hatte Schauspielerin Scarlett Johannson OpenAI verbieten lassen, ihre Stimme für ChatGPT zu verwenden. Im visionären Film “Her” spielte sie bereits 2013 eine KI-Stimme, in die sich der Hauptdarsteller Joaquin Phoenix verliebt. Diesen Science-Fiction-Filmstoff wollte OpenAI nun Realität werden lassen und ihre Stimme für Gespräche mit ChatGPT verwenden, allerdings ohne die Schauspielerin um Erlaubnis zu fragen.

Über 30.000 weitere Schauspieler und Musiker hatten jüngst einen offenen Brief veröffentlicht, mit der Forderung, KI zu untersagen, ihre Werke als Trainingsdaten verwenden zu dürfen, darunter ABBA, Radiohead, Julianne Moore, The Cure, Hot Chip und viele andere. Bereits jetzt wäre es problemlos möglich, unendlich viele KI-generierte ABBA-Songs zu generieren durch das immer neue Zusammensetzen des vorhandenen Repertoires. Für Kreative: eine Horrorvorstellung. Für die Musikindustrie: ein Traum. Denn so muss man keine Künstler mehr aufbauen und kann einfach das, was am meisten Geld bringt in immer neuen Varianten auf den Markt werfen.

Der Widerstand gegen KI wächst aber auch in der Bevölkerung und die Ängste vieler Menschen durch die rasante technologische Entwicklung bald keine Arbeit mehr zu haben sind nicht unbegründet. Und diese Angst vergiftet das politische Klima weiter.

EU Regulierung tritt 2025 in Kraft

Ab August 2025 müssen die Regeln des AI Act der EU für allgemeine KI-Modelle, wie ChatGPT, erfüllt sein. Dazu zählen unter anderem Transparenzanforderungen, durch die Nutzer erkennen sollen, wann sie mit einem KI-System interagieren und wie dieses trainiert wurde. Auch sogenannte Hochrisiko-KI-Modell zur Erfassung sensibler Daten wie Biometrie, Scoring oder Gesundheit unterliegen strengen Auflagen, die ab 2026 verpflichtend werden. Es ist also noch gar nicht gesagt, dass die aktuellen Systeme zukunftsfähig sind, weil sie ggf. gegen rechtliche Vorgaben verstoßen.

Auch die Gefahr von Verzerrungen und Diskriminierung ist groß. KI-Systeme übernehmen oft Stereotype aus ihren Trainingsdaten, was zu unfairen oder sogar diskriminierenden Ergebnissen führen kann. Man stelle sich nur vor, welche Antworten vergleichbare KI-Tools in Ländern mit staatlicher Zensur geben werden. KI lässt sich problemlos als Instrument zur Gehirnwäsche umfunktionieren.

“Big Brother” aus dem Roman “1984” ist in manchen Ländern keine Dystopie mehr, es ist längst Realität. KI kann sehr realistisch wirkende Texte, Bilder und Videos generieren und Meinungen nach Wunsch manipulieren. Und das ist eine große Gefahr, sofern man gleichzeitig die Arbeit von unabhängigen Medien einschränkt.

KI-Generatoren machen faul und dumm

Aber es geht auch eine Nummer kleiner: wenn immer mehr Aufgaben an KI übergeben werden, fehlt Menschen die Möglichkeit, ihre Fähigkeiten weiterzuentwickeln, was irgendwann zum Problem wird. Wenn Routineaufgaben automatisch erledigt werden, fehlt oft die Motivation zur Eigeninitiative und Weiterentwicklung. Dies könnte langfristig die Produktivität und Innovationskraft verringern. Mit anderen Worten: KI macht uns faul und dumm. Wir sind irgendwann nicht mehr in der Lage einen geraden Satz zu formulieren, wenn wir die Kulturtechnik des Schreibens aufgeben. Wir sehen, was mit unserer Handschrift passiert ist, seit wir nicht mehr von Hand schreiben. Dasselbe wird passieren, wenn wir gar nichts mehr selbst schreiben.

Entwickler, die das Coding nur noch an KI-Generatoren auslagern, werden nach und nach ihre Fähigkeiten und den Anschluss verlieren. Warum sollte man noch jemanden für viel Geld einstellen, der nur automatisch generierten Code erzeugen lässt? Manche Entwickler sagen sogar voraus, dass Entwickler in 1-2 Jahren gar nicht mehr gebraucht werden, aber wer überprüft dann diesen Code? Wer kontrolliert die Maschine?

Ein Verlag hat angekündigt im kommenden Jahr 8000 KI-generierte Bücher auf den Markt zu werfen. Fehlt eigentlich nur eine KI, die diesen ganzen Spam konsumieren möchte.

Sprachmodelle können nicht bewerten und haben kein Gewissen

Ethisch und sozial problematisch wird KI, wenn wichtige Entscheidungen im Gesundheitswesen oder der Justiz zunehmend auf automatisierten Modellen basieren und nicht auf individuellen Bewertungen. Dies könnte das Vertrauen in Institutionen untergraben. KI-Modelle haben keine menschlichen Eigenschaften und kein Mitgefühl. Deshalb können sie keine gut abgewogenen Entscheidungen treffen.

All diese Faktoren zeigen, dass der verantwortungsvolle Umgang mit KI regelmäßig überprüft werden muss, damit sie der Gesellschaft nicht schadet. Regulierung bedeutet in diesem Zusammenhang nichts Negatives: Man muss KI regulieren, weil es zu viele Gefahren gibt und zu große finanzielle Interessen von Menschen mit sehr viel Geld und Macht. Nur solche können noch neue KI-Modelle entwickeln und vermarkten.

KI-Technologie ist eine echte Bedrohung für den gesellschaftlichen Zusammenhalt, sie verschärft die bereits vorhandene Spaltung der Gesellschaft in reich und arm noch einmal massiv.

Generative KI und die Zukunft: Zwischen Potential und Realität

Die aktuelle Debatte um KI zeigt, dass es auf Dauer nicht reicht, sich nur von den beeindruckenden neuen technischen Möglichkeiten und der oberflächliche Einfachheit von KI-Tools blenden zu lassen, zumal viele der Jubelmeldungen nichts anderes als PR der KI-Unternehmen sind, die mit extrem viel Geld ihre Produkte in den Markt drücken wollen, bevor ein anderes Unternehmen ihnen diesen streitig macht.

Wir müssen uns aber auch mit den Folgen für die Menschen auseinandersetzen. Auch wenn die Sprachmodelle beeindruckende Fortschritte gemacht haben, bleibt die Frage, was wir eigentlich damit machen wollen und wem sie langfristig nutzen – und vor allem: wem sie schaden.

Wissenschaftler der Universität Washington sprechen im Zusammenhang mit generativer KI sogar ganz unverblümt von einem Angriff auf die Wissenschaft:

“Die Fähigkeit, unbegrenzt plausibel aussehenden Müll praktisch kostenlos zu produzieren, ist ein DDoS-Angriff auf schriftlich festgehaltenes Wissen.” Quelle

Mit KI werden durchaus hilfreiche Werkzeuge für Routineaufgaben entstehen, aber die Grenzen und möglichen negativen Auswirkungen auf unsere Gesellschaft dürfen bei aller Begeisterung für den technologischen Fortschritt nicht übersehen werden. KI macht unsere Welt nicht etwa einfacher, sondern im Gegenteil, wesentlich komplizierter als sie sowieso schon ist.

Generative KI ist eine Lösung für ein Problem, das wir nie hatten.

Sie ist ein Geschäftsmodell für wenige, die von der Arbeit vieler profitieren möchten. Der einzige Vorteil den diese Tools bieten ist, dass ihre Nutzer faul werden und Informationen nicht mehr überprüfen können. Das ist weder fair noch nachhaltig und muss bekämpft werden.

Die Studienlage: Risiken und Nebenwirkungen von generativer KI

Eine Übersicht aktueller wissenschaftlicher Studien zeigt die potenzielle Risiken und Probleme im Zusammenhang mit generativer KI:

Ethische Risiken und Diskriminierung

- Studien zeigen, dass generative KI-Systeme Stereotypen und Vorurteile aus Trainingsdaten übernehmen und reproduzieren können, was zu Diskriminierung führen kann.

- Forschende warnen vor dem Risiko, dass Nutzer KI-Systemen übermäßig vertrauen und dadurch sensible Informationen preisgeben oder Ausgaben nicht ausreichend hinterfragen.

Desinformation und Manipulation

- Untersuchungen belegen das Potenzial generativer KI zur automatisierten Erstellung und Verbreitung von Falschinformationen in großem Umfang.

- Studien zeigen, wie KI-generierte “Deepfakes” für Wahlmanipulation und politische Polarisierung missbraucht werden können.

Datenschutz und Privatsphäre

- Forschende warnen vor Risiken für die Privatsphäre durch KI-basiertes Online-Tracking und Profiling von Einzelpersonen.

- Studien belegen die Möglichkeit, private Informationen aus Sprachmodellen zu extrahieren.

Wirtschaftliche und ökologische Folgen

- Untersuchungen prognostizieren negative Auswirkungen auf den Arbeitsmarkt durch KI-bedingte Jobverluste.

- Studien kritisieren den immensen Energieverbrauch beim Training und Betrieb großer KI-Modelle.

Sicherheitsrisiken

- Forschende warnen vor dem Missbrauch generativer KI zur Erstellung von Schadcode für Cyberangriffe.

- Studien zeigen Sicherheitsrisiken durch KI-Systeme, die physisch mit Menschen interagieren oder implantiert werden.

Mangelnde Transparenz

- Untersuchungen kritisieren die fehlende Nachvollziehbarkeit von KI-Entscheidungen (“Black Box”-Problem).

- Studien belegen, dass es für Nutzer oft unklar ist, ob sie mit einer KI oder einem Menschen interagieren.

Urheberrechtsverletzungen beim KI-Training

Die Studien belegen, dass das Training generativer KI-Modelle in mehrfacher Hinsicht gegen geltendes Urheberrecht verstößt:

- Bei der Sammlung, Aufbereitung und Speicherung der Trainingsdaten kommt es zu urheberrechtlich relevanten Vervielfältigungen geschützter Werke.

- Während des Trainings werden Teile der Trainingsdaten von den KI-Modellen memoriert und können später reproduziert werden, was ebenfalls eine Urheberrechtsverletzung darstellt.

- Die Bereitstellung trainierter KI-Modelle zur Nutzung wird als öffentliche Zugänglichmachung der verarbeiteten Werke eingestuft und verletzt damit ebenfalls Urheberrechte.

Keine Abdeckung durch bestehende Regelungen

Die Studien stellen klar, dass das Training generativer KI-Modelle nicht unter die Schrankenregelung für Text- und Data-Mining (TDM) fällt:

- Die TDM-Schranke des europäischen und deutschen Rechts (Art. 3 DSM-RL und § 44b UrhG) ist auf KI-Training nicht anwendbar.

- Es gibt derzeit keine gültige urheberrechtliche Schranke oder Erlaubnis für das Training generativer KI-Modelle.

Rechtliche Konsequenzen

Die Studien kommen zu dem Schluss, dass das Training generativer KI ohne Einwilligung der Rechteinhaber als rechtswidrig einzustufen ist:

- Es handelt sich um einen “groß angelegten Diebstahl am geistigen Eigentum”24.

- Die Bereitstellung von KI-Diensten in der EU kann als Urheberrechtsverletzung gewertet werden.

- Es werden Forderungen nach Konsequenzen und einer Regulierung laut, um die Rechte von Urhebern zu schützen.

Quellen:

https://www.nomos.de/training-generativer-ki-modelle-und-die-tuecken-des-urheberrechts/

https://kulturrat-nrw.de/urheberrecht-training-generativer-ki-technologische-und-rechtliche-grundlagen-studie-der-initiative-urheberrecht/

https://illustratoren-organisation.de/2024/09/11/neue-studie-belegt-ki-training-verletzt-urheberrechte/

https://bfs-filmeditor.de/mehr-erfahren/news/studie-der-initiative-urheberrecht-ki-training-ist-eine-urheberrechtsverletzung

https://www.regieverband.de/aktuelles/2024-09_studie-der-initiative-urheberrecht-deckt-auf-ki-training-ist-eine-eklatante

https://urheber.info/diskurs/ki-training-ist-urheberrechtsverletzung

https://www.heise.de/news/Studie-fuer-Rechteinhaber-KI-Training-ist-Urheberrechtsverletzung-9860401.html

https://medienpolitik.net/aktuelle-themen/ki-training-kann-das-urheberrecht-verletzen-554

https://www.europarl.europa.eu/topics/de/article/20200918STO87404/kunstliche-intelligenz-chancen-und-risiken

https://www.lmu.de/de/newsroom/newsuebersicht/news/kuenstliche-intelligenz-die-flut-gefaelschter-fakten.html

https://www.bidt.digital/themenmonitor-kuenstliche-intelligenz/

https://ambient.digital/wissen/blog/kuenstliche-intelligenz-chancen-risiken/

https://www.zdf.de/nachrichten/wissen/kuenstliche-intelligenz-luegen-betruegen-100.html

https://www.ifo.de/DocDL/sd-2023-08-ki-chancen-risiken.pdf

https://www.ifo.de/DocDL/sd-2023-08-kuenstliche-intelligenz.pdf

Kontakt

Sie brauchen zuverlässige Unterstützung zum Thema Suchmaschinenoptimierung und Content? Fragen Sie nach einer unverbindlichen Erstberatung mit kostenlosem SEO-Check Ihrer Website.